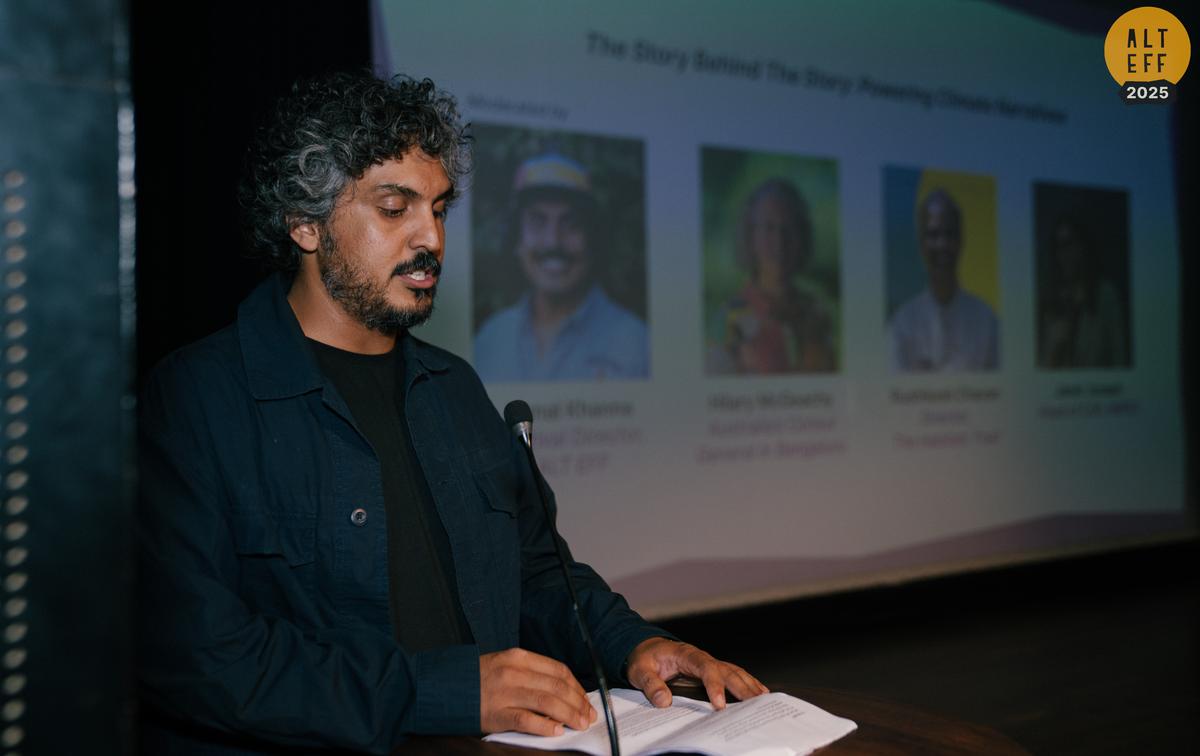

Festival de Cinema Ambiental All Living Things no BIC em Bengaluru | Crédito da foto: Deva Manohar Manoj

O fim de semana de abertura do All Living Things Environmental Film Festival (ALT EFF) em Bengaluru foi sobre conversas urgentes sobre o meio ambiente e onde esses diálogos se desdobraram através da linguagem do cinema.

O público teve um vislumbre de sistemas de esgoto e aterros, parques solares e zonas húmidas, fungos e florestas, teatro folclórico e experiências imersivas, muitas vezes numa única tarde. Para o diretor e cofundador do festival, Kunal Khanna, um economista que se tornou pensador de sistemas e permacultor, o objetivo era claro: reunir uma série de filmes que proporcionassem uma forma de as pessoas agirem.

Um painel de discussão em ação | Crédito da foto: Deva Manohar Manoj

Histórias humanas, o coração do cinema climático

Nas diversas salas do Centro Internacional de Bangalore (BIC) onde o festival foi realizado, a importância do meio ambiente nunca pareceu distante; apareceu em aldeias, cidades, fábricas e florestas. De histórias como Kentaro (Tilmann Stewart, Gaku Matsuda) e Futuro Conselho (Damon Gameau) fazendo-nos ver o “futuro” através dos olhos das crianças, para Marchando no escuro (Kinshuk Surjan) acompanhando mulheres que vivem com as consequências dos suicídios de agricultores e da negligência institucional e O Mundo Dooars (Shaon Pritam Baral) Ao entrar num corredor frágil onde a vida selvagem e as pessoas coexistem, o festival destacou os seus princípios fundamentais de mudança.

De acordo com a equipe por trás do ALT EFF, os recursos apresentados não eram apenas sobre o meio ambiente, mas também sobre a compreensão da conexão humana com ele.

“Os grandes cineastas estão a apoiar as narrativas ambientais, e estas histórias são tão fortes que o subgénero é sobre o ambiente, e a narrativa principal é a emoção humana”, diz Laura Christe Khanna, que também é cofundadora e produtora do festival.

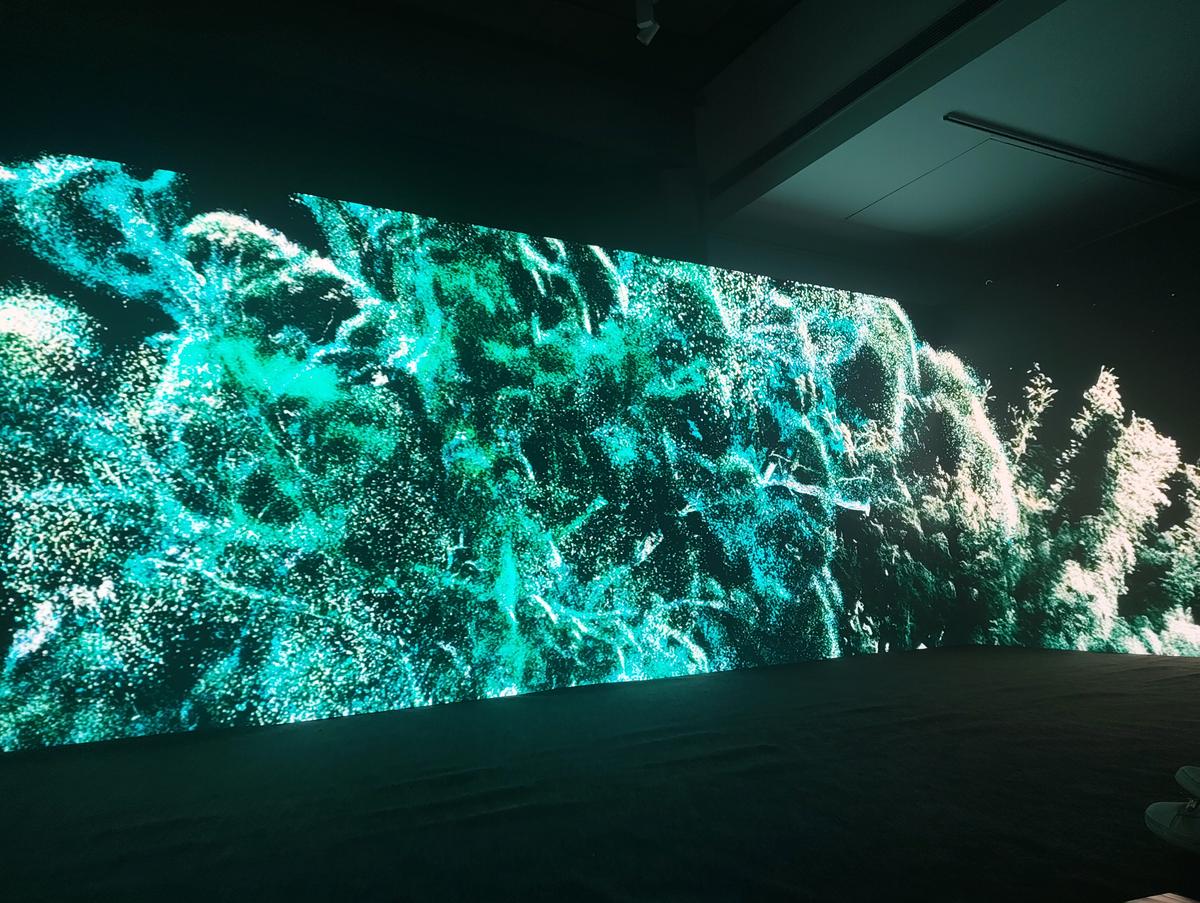

A mensagem mantém um delicado equilíbrio entre urgência ecológica e imediatismo emocional, algo que é deliberado e não acidental. Mesmo no palco, apresentações como Cuidado com o Asura de plásticosobre um demônio Yakshagana que personifica nosso problema plástico, promoveu ideias de transformação, enquanto experiências artísticas imersivas como Os Gigantestransportou o público para o coração das antigas florestas da Austrália.

Diretor e cofundador do festival, Kunal Khanna | Crédito da foto: Arranjo especial

Clima caseiro na tela grande

Embora o festival abrangesse experiências de todo o mundo, o seu olhar nunca saiu de casa por muito tempo. Documentários como Descendo pelo ralouma jornada de observação pelo sistema de esgoto da cidade, e Resíduos e a cidadeuma revisitação de Mavallipura após anos de protestos e despejos, voltou o foco para as ruas, tubulações e aterros de Bengaluru.

Nitya Misra (Descendo pelo ralo) e Vishwesh Bhagirathi Shivaprasad com Karishma Rao (Resíduos e a cidade) creditam a ALT EFF como uma plataforma para o público assumir responsabilidades, bem como promover justiça positiva.

No mesmo espírito, Abaixo do painel: as perdas ocultas dos parques solares da Índiadirigido por Aparna Ganesan, também fez perguntas sérias sobre o que acontece com as pessoas deslocadas em nome da energia limpa e deu ao público muito em que pensar.

Experiência imersiva intitulada Os Gigantes

| Crédito da foto: Deva Manohar Manoj

Falando sobre o futuro, Kunal está otimista de que festivais como o ALT EFF, de natureza descentralizada, eventos realizados em várias cidades e uma rede crescente de watch parties, contribuirão muito para sensibilizar as pessoas para as questões candentes que cercam o planeta.

Publicado – 10 de dezembro de 2025, 15h17 IST