O CEO da Open AI, Sam Altman, fala durante uma sessão de conversa com o CEO do Grupo SoftBank, Masayoshi Son, em um evento intitulado “Transformando negócios por meio da IA” em Tóquio, em 3 de fevereiro de 2025.

Tomohiro Ohsumi | Imagens Getty

Em novembro, após a última queda nos lucros da Nvidia, o CEO Jensen Huang vangloriou-se aos investidores sobre a posição de sua empresa em inteligência synthetic e disse sobre a startup mais quente do setor: “Tudo o que a OpenAI faz hoje funciona na Nvidia”.

Embora seja verdade que a Nvidia mantém uma posição dominante em chips de IA e é agora a empresa mais valiosa do mundo, a concorrência está a emergir e a OpenAI está a fazer tudo o que pode para diversificar, à medida que prossegue um plano de expansão historicamente agressivo.

Na quarta-feira, a OpenAI anunciou um acordo de US$ 10 bilhões com a fabricante de chips Cerebras, um participant relativamente incipiente no setor, mas que está buscando o mercado público. Foi o mais recente de uma série de acordos entre a OpenAI e as empresas que fabricam os processadores necessários para construir grandes modelos de linguagem e executar cargas de trabalho cada vez mais sofisticadas.

No ano passado, a OpenAI comprometeu mais de US$ 1,4 trilhão em acordos de infraestrutura com empresas como Nvidia, Microdispositivos avançados e Broadcoma caminho de comandar uma avaliação de mercado privado de US$ 500 bilhões.

À medida que a OpenAI corre para atender à demanda prevista por sua tecnologia de IA, ela sinalizou ao mercado que deseja o máximo de poder de processamento possível. Aqui estão os principais acordos de chips que a OpenAI assinou em janeiro e parceiros em potencial para ficar de olho no futuro.

Nvidia

O fundador e CEO da Nvidia, Jensen Huang, fala durante o Nvidia Stay na CES 2026 antes do Client Electronics Present anual em Las Vegas, 5 de janeiro de 2026.

Patrick T. Fallon | Afp | Imagens Getty

Desde o início da construção de grandes modelos de linguagem, muito antes do lançamento do ChatGPT e do início do increase da IA generativa, a OpenAI confiou nas unidades de processamento gráfico da Nvidia.

Em 2025, essa relação foi para outro patamar. Após um investimento na OpenAI no closing de 2024, a Nvidia anunciou em setembro que comprometeria US$ 100 bilhões para apoiar a OpenAI enquanto ela constrói e implanta pelo menos 10 gigawatts de sistemas Nvidia.

Um gigawatt é uma medida de energia, e 10 gigawatts equivalem aproximadamente ao consumo anual de energia de 8 milhões de lares nos EUA, de acordo com uma análise da CNBC de dados da Administração de Informação de Energia. Huang disse em setembro que 10 gigawatts equivalerão a entre 4 milhões e 5 milhões de GPUs.

“Este é um projeto gigante”, disse Huang à CNBC na época.

OpenAI e Nvidia disseram que a primeira fase do projeto deverá estar on-line no segundo semestre deste ano na plataforma Vera Rubin da Nvidia. No entanto, durante a teleconferência de resultados trimestrais da Nvidia em novembro, a empresa disse que “não há garantia” de que seu acordo com a OpenAI irá além de um anúncio e para uma fase de contrato oficial.

O primeiro investimento da Nvidia de US$ 10 bilhões será realizado quando o primeiro gigawatt for concluído, e os investimentos serão feitos com base nas avaliações atuais, conforme relatado anteriormente pela CNBC.

AMD

Lisa Su, presidente e CEO da Superior Micro Units Inc., exibe uma GPU AMD Intuition MI455X durante o evento CES 2026 em Las Vegas, 5 de janeiro de 2026.

Bloomberg | Bloomberg | Imagens Getty

Em outubro, a OpenAI anunciou planos para implantar seis gigawatts de GPUs da AMD ao longo de vários anos e múltiplas gerações de {hardware}.

Como parte do acordo, a AMD emitiu à OpenAI um warrant para até 160 milhões de ações ordinárias da AMD, o que poderia equivaler a uma participação de cerca de 10% na empresa. O mandado inclui marcos de aquisição vinculados ao quantity de implantação e ao preço das ações da AMD.

As empresas afirmaram que planejam lançar o primeiro gigawatt de chips no segundo semestre de 2026 e acrescentaram que o negócio vale bilhões de dólares, sem divulgar valor específico.

“Você precisa de parcerias como essa que realmente unam o ecossistema para garantir que, você sabe, possamos realmente obter as melhores tecnologias, você sabe, por aí”, disse a CEO da AMD, Lisa Su, à CNBC no momento do anúncio.

Altman plantou as sementes do negócio em junho, quando apareceu no palco ao lado de Su em um evento de lançamento da AMD em San Jose, Califórnia. Ele disse que a OpenAI planeja usar os chips mais recentes da AMD.

Broadcom

CEO da Broadcom, Hock Tan.

Lucas Jackson | Reuters

Mais tarde naquele mês, OpenAI e Broadcom revelaram publicamente uma colaboração que estava em andamento há mais de um ano.

A Broadcom chama seus chips de IA personalizados de XPUs e, até agora, tem contado com alguns clientes. Mas o seu conjunto de potenciais negócios despertou tanto entusiasmo em Wall Avenue que a Broadcom está agora avaliada em mais de 1,6 biliões de dólares.

A OpenAI disse que está projetando seus próprios chips e sistemas de IA que serão desenvolvidos e distribuídos pela Broadcom. As empresas concordaram em implantar 10 gigawatts desses aceleradores de IA personalizados.

No comunicado de outubro, as empresas disseram que a Broadcom terá como objetivo começar a implantar racks do acelerador de IA e sistemas de rede até o segundo semestre deste ano, com a meta de concluir o projeto até o closing de 2029.

Mas o CEO da Broadcom, Hock Tan, disse aos investidores durante a teleconferência de resultados trimestrais da empresa em dezembro que não espera muitas receitas da parceria OpenAI em 2026.

“Apreciamos o facto de ser uma jornada de vários anos que durará até 2029”, disse Tan. “Eu chamo isso de acordo, um alinhamento de onde estamos indo.”

OpenAI e Broadcom não divulgaram os termos financeiros do acordo.

Cérebros

Andrew Feldman, cofundador e CEO da Cerebras Techniques, fala na conferência Collision em Toronto, 20 de junho de 2024.

Ramsey Cardy | Arquivo esportivo | Colisão | Imagens Getty

OpenAI na quarta-feira anunciou um acordo para implantar 750 megawatts de chips de IA da Cerebras que estarão online em várias parcelas até 2028.

A Cerebras constrói grandes chips em escala de wafer que podem fornecer respostas até 15 vezes mais rápidas do que sistemas baseados em GPU, de acordo com um lançamento. A empresa é muito menor que Nvidia, AMD e Broadcom.

O acordo da OpenAI com a Cerebras vale mais de US$ 10 bilhões e pode ser uma vantagem para a fabricante de chips, já que avalia uma possível estreia nos mercados públicos.

“Estamos muito satisfeitos com a parceria com a OpenAI, trazendo os principais modelos de IA do mundo para o processador de IA mais rápido do mundo”, disse o CEO da Cerebras, Andrew Feldman, em um comunicado.

A Cerebras precisa urgentemente de clientes de destaque. Em outubro, a empresa retirou-se planeja um IPO, dias depois de anunciar que levantou mais de US$ 1 bilhão em uma rodada de arrecadação de fundos. Ela havia entrado com pedido de oferta pública um ano antes, mas seu prospecto revelava uma forte dependência de um único cliente nos Emirados Árabes Unidos, o G42, apoiado pela Microsoft, que também é investidor da Cerebras.

Parceiros potenciais

Sam Altman, CEO da OpenAI, fala durante um tour de mídia pelo information middle Stargate em Abilene, Texas, em 23 de setembro de 2025. Stargate é uma colaboração da OpenAI, Oracle e SoftBank, com apoio promocional do presidente Donald Trump, para construir information facilities e outras infraestruturas para inteligência synthetic em todos os EUA

Kyle Grillot | Bloomberg | Imagens Getty

Onde isso deixa Amazônia, Google e Intel, que possuem seus próprios chips de IA?

Em novembro, a OpenAI assinou um acordo de nuvem de US$ 38 bilhões com Amazon Internet Companies. A OpenAI executará cargas de trabalho por meio de information facilities existentes da AWS, mas o provedor de nuvem também planeja construir infraestrutura adicional para a startup como parte do acordo.

A Amazon também está em negociações para investir potencialmente mais de US$ 10 bilhões em OpenAI, conforme relatado anteriormente pela CNBC.

A OpenAI poderia decidir usar os chips de IA da Amazon como parte dessas discussões de investimento, mas nada oficial foi determinado, segundo uma pessoa com conhecimento do assunto que pediu para não ser identificada porque as discussões são confidenciais.

A AWS anunciou seus chips Inferentia em 2018 e a última geração de seus chips Trainium no closing de 2025.

Google Nuvem também fornece capacidade computacional à OpenAI graças a um acordo que foi discretamente finalizado no ano passado. Mas OpenAI disse em junho que não tem planos de usar chips internos do Google, chamados unidades de processamento tensor, que a Broadcom também ajuda a produzir.

A Intel tem sido a maior retardatária em IA entre os fabricantes de chips tradicionais, o que explica por que a empresa recentemente recebeu investimentos maciços do governo dos EUA e da Nvidia. Reuters relatado em 2024, citando pessoas com conhecimento das discussões, que a Intel teve an opportunity de investir em OpenAI anos antes e potencialmente fabricar {hardware} para a startup então incipiente, oferecendo-lhe uma maneira de evitar a dependência da Nvidia.

A Intel decidiu contra o acordo, segundo a Reuters.

Em outubro, a Intel anunciado uma nova GPU de information middle com o codinome Crescent Island e diz ser “projetada para atender às demandas crescentes de cargas de trabalho de inferência de IA e oferecerá alta capacidade de memória e desempenho com eficiência energética”. A empresa disse que a “amostragem de clientes” é esperada para o segundo semestre de 2026.

Wall Avenue ouvirá atualizações sobre os mais recentes esforços de IA da Intel quando a empresa iniciar a temporada de lucros de tecnologia na próxima semana.

— Kif Leswing da CNBC, MacKenzie Sigalos e Jordan Novet contribuíram para este relatório.

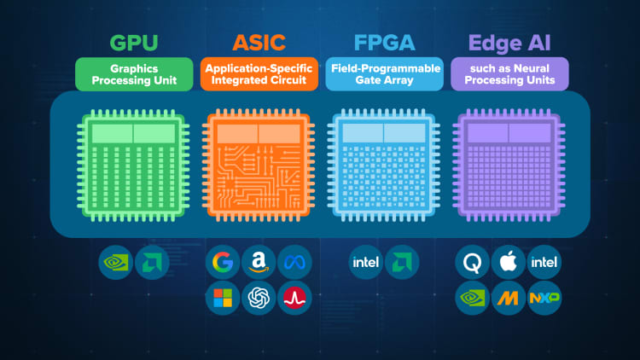

ASSISTIR: Dividindo chips de IA, de GPUs Nvidia a ASICs do Google e Amazon