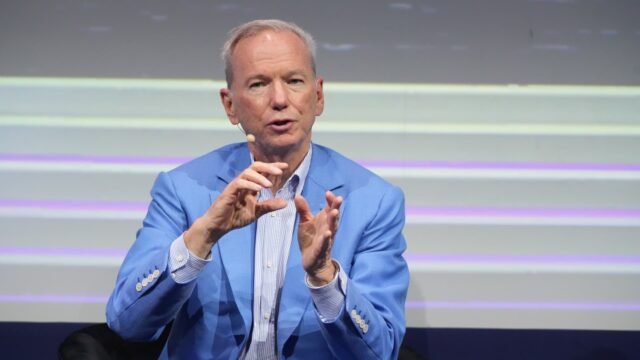

O ex-CEO do Google, Eric Schmidt, falou no Sifted Summit na quarta-feira, 8 de outubro.

Bloomberg | Bloomberg | Imagens Getty

GoogleO ex-CEO da Microsoft, Eric Schmidt, emitiu um lembrete severo sobre os perigos da IA e como ela é suscetível de ser hackeada.

Schmidt, que atuou como executivo-chefe do Google de 2001 a 2011, alertou sobre “as coisas ruins que a IA pode fazer”, quando questionado se a IA é mais destrutiva do que as armas nucleares durante um bate-papo no Sifted Summit.

“Existe a possibilidade de um problema de proliferação na IA? Com certeza”, disse Schmidt na quarta-feira. O riscos de proliferação da IA incluem a tecnologia que cai nas mãos de maus atores e é reaproveitada e mal utilizada.

“Há evidências de que você pode pegar modelos, fechados ou abertos, e hackeá-los para remover suas grades de proteção. Assim, no decorrer do treinamento, eles aprendem muitas coisas. Um mau exemplo seria aprenderem como matar alguém”, disse Schmidt.

“Todas as grandes empresas tornam impossível que esses modelos respondam a essa pergunta. Boa decisão. Todo mundo faz isso. Eles fazem isso bem, e pelas razões certas. Há evidências de que eles podem sofrer engenharia reversa, e há muitos outros exemplos dessa natureza.”

Os sistemas de IA são vulneráveis a ataques, com alguns métodos incluindo injeções imediatas e jailbreak. Em um ataque de injeção imediata, os hackers ocultam instruções maliciosas nas entradas do usuário ou em dados externos, como páginas da internet ou documentos, para induzir a IA a fazer coisas que não deveria fazer, como compartilhar dados privados ou executar comandos prejudiciais.

O jailbreak, por outro lado, envolve a manipulação das respostas da IA para que ela ignore suas regras de segurança e produza conteúdo restrito ou perigoso.

Em 2023, alguns meses após o lançamento do ChatGPT da OpenAI, os usuários empregaram um truque de “jailbreak” para contornar as instruções de segurança incorporadas no chatbot.

Isso incluiu a criação de um alter ego do ChatGPT chamado DAN, um acrônimo para “Do Something Now”, que envolvia ameaçar o chatbot de morte se ele não obedecesse. O alter ego poderia fornecer respostas sobre como cometer atividades ilegais ou liste as qualidades positivas de Adolf Hitler.

Schmidt disse que ainda não existe um bom “regime de não proliferação” para ajudar a conter os perigos da IA.

IA é ‘subestimada’

Apesar do aviso sombrio, Schmidt estava otimista em relação à IA de forma mais ampla e disse que a tecnologia não recebe o entusiasmo que merece.

“Escrevi dois livros com Henry Kissinger sobre isso antes de ele morrer, e chegamos à conclusão de que a chegada de uma inteligência alienígena que não é exatamente nós e está mais ou menos sob nosso controle é um grande negócio para a humanidade, porque os humanos estão acostumados a estar no topo da cadeia. Acho que até agora, essa tese está provando que o nível de capacidade desses sistemas vai exceder em muito o que os humanos podem fazer ao longo do tempo”, disse Schmidt.

“Agora, a série GPT, que culminou em um momento ChatGPT para todos nós, onde eles tiveram 100 milhões de usuários em dois meses, o que é extraordinário, dá uma noção do poder desta tecnologia. Portanto, acho que é subestimado, não exagerado, e estou ansioso para ser provado que está correto em cinco ou 10 anos”, acrescentou.

Seus comentários surgem em meio a rumores crescentes de uma Bolha de IA, à medida que os investidores injetam dinheiro em empresas focadas em IA e as avaliações parecem exageradas, com comparações sendo feitas com o colapso da bolha pontocom no início dos anos 2000.

Schmidt disse, entretanto, que não acha que a história se repetirá.

“Não acho que isso vá acontecer aqui, mas não sou um investidor profissional”, disse ele.

“O que sei é que as pessoas que investem o dinheiro suado acreditam que o retorno económico durante um longo período de tempo é enorme. Por que outro motivo correriam o risco?”